كشف حملة برمجيات خبيثة أنشطة Anatsa تستهدف مستخدمي أندرويد في أمريكا الشمالية عبر متجر جوجل

اكتشف باحثو الأمن السيبراني حملة خبيثة على نظام أندرويد تستخدم تروجانًا يُعرف باسم Anatsa لاستهداف مستخدمي الهواتف في أمريكا الشمالية، من خلال تطبيقات خبيثة تم نشرها على متجر جوجل الرسمي.

كيف يعمل الفيروس؟

التطبيق الخبيث كان يظهر على هيئة تحديث PDF Update لتطبيق قارئ مستندات، لكنه يعرض نافذة خداعية عندما يحاول المستخدمون فتح تطبيقاتهم البنكية، تفيد بأن الخدمة معلقة مؤقتًا للصيانة المجدولة.

قالت شركة ThreatFabric الهولندية المتخصصة في الأمن المحمول في تقرير لها:

“هذه هي المرة الثالثة على الأقل التي تركز فيها Anatsa هجماتها على عملاء البنوك عبر الهواتف المحمولة في الولايات المتحدة وكندا، ويتم توزيعها عبر متجر Google Play الرسمي.”

تاريخ Anatsa

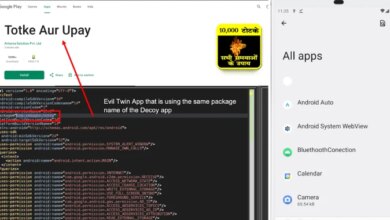

برمجية Anatsa المعروفة أيضاً باسم TeaBot وToddler نشطة منذ 2020، وتنتشر غالبًا عبر تطبيقات تبدو عادية في البداية. في 2024، استهدفت مستخدمي أندرويد في سلوفاكيا وسلوفينيا والتشيك، حيث يتم نشر التطبيقات المبدئية التي تبدو بريئة مثل قارئ PDF ومنظف هاتف، قبل إضافة الكود الخبيث بعد أسبوع من النشر.

قدرات البرمجية الخبيثة

تتميز Anatsa بقدرتها على سرقة بيانات الدخول البنكية عبر تقنيات التراكب (overlay) وتسجيل ضغطات المفاتيح (keylogging)، بالإضافة إلى تنفيذ عمليات احتيال مالية من أجهزة الضحايا عبر التحكم الكامل.

يتم إنشاء حساب مطور على متجر التطبيقات لنشر تطبيق شرعي يعمل بشكل طبيعي. وبعد وصول عدد التنزيلات إلى آلاف أو عشرات الآلاف، يتم تحديث التطبيق ليحمل الكود الخبيث الذي يثبت Anatsa كبرنامج مستقل على الجهاز.

تفاصيل الحملة الأخيرة

التطبيق المستهدف لأمريكا الشمالية ظهر تحت اسم Document Viewer (حزمة APK: “com.stellarastra.maintainer.astracontrol_managerreadercleaner”) وتم نشره بواسطة حساب مطور باسم “Hybrid Cars Simulator, Drift & Racing”، وكلاهما غير متوفران حاليًا على متجر Google Play.

بحسب بيانات Sensor Tower، نُشر التطبيق في 7 مايو 2025، ووصل إلى المركز الرابع في فئة “الأدوات المجانية” في 29 يونيو 2025، وقد تم تنزيله حوالي 90,000 مرة.

قالت ThreatFabric:

“هذا التطبيق اتبع أسلوب Anatsa المعتاد: إطلاق تطبيق شرعي في البداية، ثم تحويله إلى تطبيق خبيث بعد حوالي 6 أسابيع. استمر التوزيع من 24 إلى 30 يونيو، وكان تأثيره كبيرًا رغم قصر المدة.”

مميزات إضافية

يُظهر التطبيق رسالة صيانة مزيفة عند محاولة فتح تطبيقات البنوك المستهدفة، مما يمنع العملاء من الاتصال بالدعم ويؤخر اكتشاف الاحتيال.

كما تم ضبط البرمجية لتستهدف مجموعة واسعة من تطبيقات البنوك في الولايات المتحدة، مما يعكس تركيزها المتزايد على القطاع المالي في المنطقة.

نصيحة للمنظمات المالية

حثت ThreatFabric المؤسسات المالية على مراجعة هذه المعلومات وتقويم المخاطر المحتملة وتأثيرها على العملاء وأنظمتهم.