Shadow AI: التحديات الخفية لتبني الذكاء الاصطناعي في المؤسسات

الحقيقة القاسية لاعتماد الذكاء الاصطناعي في المؤسسات

كشف تقرير MIT عن حالة الذكاء الاصطناعي في الأعمال أن 40% من المؤسسات اشترت اشتراكات رسمية في نماذج اللغة الكبيرة (LLMs)، بينما أكثر من 90% من الموظفين يستخدمون أدوات الذكاء الاصطناعي يوميًا. والأخطر أن 45.4% من هذه الاستخدامات الحساسة تتم عبر حسابات بريد شخصية، متجاوزين أنظمة الرقابة المؤسسية.

هذا الوضع أدى إلى ظهور ما يُعرف بـ اقتصاد Shadow AI، أي الاستخدام غير المُدار للذكاء الاصطناعي داخل المؤسسات.

تبني الذكاء الاصطناعي: من القاعدة إلى القمة

تخطئ المؤسسات حين تعتقد أن استخدام الذكاء الاصطناعي قرار يُفرض من الإدارة العليا. الواقع مختلف: الموظفون هم من يقودون التبني من الأسفل إلى الأعلى، غالبًا بدون إشراف، بينما لا تزال أطر الحوكمة في طور التعريف من الأعلى إلى الأسفل.

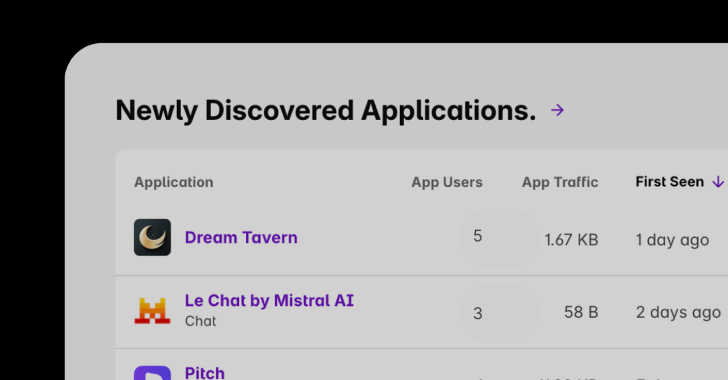

حتى في حال توفر أدوات رسمية، يميل الموظفون إلى اختيار أدوات أخرى أكثر حداثة وملاءمة لرفع إنتاجيتهم.

لماذا تفشل سياسة الحظر؟

-

بعض المؤسسات اتبعت سياسة “الحظر والانتظار” بمنع أدوات الذكاء الاصطناعي الشهيرة.

-

لكن الحظر يدفع الموظفين لاستخدام حساباتهم الشخصية أو أجهزتهم الخاصة، مما يجعل المؤسسة عمياء عن الاستخدام الفعلي.

-

اليوم أصبح الذكاء الاصطناعي مدمجًا في أغلب تطبيقات الإنتاجية مثل Canva وGrammarly وأدوات التعاون، وبالتالي لم يعد من الممكن عزله أو فصله.

اكتشاف Shadow AI: أولوية للحوكمة

-

الاحتفاظ بجرد شامل لأصول الذكاء الاصطناعي أصبح متطلبًا تنظيميًا وفقًا لتشريعات مثل قانون الذكاء الاصطناعي الأوروبي (EU AI Act).

-

من دون الاكتشاف، لا يوجد جرد؛ ومن دون جرد، لا توجد حوكمة.

-

بعض الأدوات قد تدرب نماذجها على بيانات حساسة، أو تخزن المعلومات في دول تُهدد الملكية الفكرية.

الحل يبدأ بكشف كامل لنطاق الاستخدام: سواء عبر حسابات رسمية أو شخصية.

كيف تساعد Harmonic Security؟

-

تقدم الشركة مراقبة مستمرة لاستخدام Shadow AI مع تقييمات جاهزة للمخاطر.

-

توفر رؤية شاملة للأدوات المعتمدة وغير المعتمدة، وتُطبق سياسات ذكية بناءً على:

-

حساسية البيانات.

-

دور الموظف.

-

طبيعة الأداة.

-

على سبيل المثال: يمكن السماح لفريق التسويق باستخدام أداة معينة لإنشاء المحتوى، بينما يُمنع قسم الموارد البشرية من إدخال بيانات الموظفين عبر حسابات شخصية.

الطريق إلى الأمام

-

Shadow AI باقٍ ولن يختفي، ومع توسع استخدام الذكاء الاصطناعي داخل تطبيقات SaaS، سيزداد التبني غير المُدار.

-

المؤسسات التي لا تبدأ بالكشف الآن ستجد صعوبة في فرض الحوكمة لاحقًا.

-

الحل ليس الحظر، بل الحوكمة الذكية: الموازنة بين حماية البيانات وتمكين الموظفين من الاستفادة من مزايا الذكاء الاصطناعي.